Наша математическая вселенная. В поисках фундаментальной природы реальности - Макс Тегмарк (2014)

-

Год:2014

-

Название:Наша математическая вселенная. В поисках фундаментальной природы реальности

-

Автор:

-

Жанр:

-

Серия:

-

Язык:Русский

-

Перевел:Александр Сергеев

-

Издательство:Corpus (АСТ)

-

Страниц:244

-

ISBN:978-5-17-085475-2

-

Рейтинг:

-

Ваша оценка:

Наша математическая вселенная. В поисках фундаментальной природы реальности - Макс Тегмарк читать онлайн бесплатно полную версию книги

Загадка начальных условий и загадка случайности связаны. По грубым оценкам, требуется почти гугол (10100) битов информации, чтобы описать реальное состояние всех частиц нашей Вселенной в данный момент. Каково происхождение этой информации? Традиционный ответ включает сочетание начальных условий и случайности: для описания начального состояния Вселенной необходимо множество битов, поскольку традиционные законы физики ничего об этом не говорят, а затем нам нужны дополнительные биты для описания исходов случайных процессов, которые имели место между «тогда» и «теперь». Однако ГМВ требует, чтобы всё было задано точно. Она отвергает и начальные условия, и случайность. Как же объяснить всю эту информацию? Если математическая структура достаточно проста, чтобы её можно было описать уравнениями, умещающимися на футболке, то это, честно говоря, кажется невозможным.

Давайте разберёмся с этим.

Иллюзия сложности

Сколько информации действительно содержит наша Вселенная? Информационное содержание (алгоритмическая сложность) чего-либо — это длина в битах его самого краткого самодостаточного описания. Чтобы оценить тонкость этого вопроса, сначала разберёмся, сколько информации содержит каждый из шести паттернов на рис. 12.7. На первый взгляд, два паттерна слева очень похожи. Это внешне случайные наборы 128 × 128 = 16 384 чёрных и белых пикселов. Можно предположить, что для описания каждого нужно около 16 384 битов — по одному биту для цвета каждого пиксела. Но хотя это верно для верхнего паттерна, который я построил с помощью квантового генератора случайных чисел, в нижнем есть скрытая простота: это просто двоичные цифры квадратного корня из двух. Этого простого описания достаточно для вычисления всего паттерна √2 ≈ 1,414 213 562…, что в двоичной системе счисления записывается как 1,0 100 001 010 000 110… Условно примем, что эту последовательность из 0 и 1 можно сгенерировать компьютерной программой длиной 100 битов. Тогда видимая сложность нижнего левого рисунка оказывается иллюзией: мы видим не 16 384 бита информации, а никак не более 100.

Рис. 12.7. Сложность паттерна (сколько битов информации нужно для его описания) не всегда очевидна. Слева вверху 128 × 128 = 16 384 квадрата, которые случайным образом окрашены в чёрный или белый цвет, что обычно нельзя описать, используя менее 16 384 битов. Маленькие фрагменты этого паттерна (вверху посередине и справа) состоят из меньшего числа случайным образом окрашенных квадратов, а значит, их описание требует меньше битов. С другой стороны, нижний левый узор может быть сгенерирован очень короткой (скажем, 100-битовой) программой, поскольку это просто двоичные цифры числа √2 (0 = чёрный квадрат, 1 = белый). Для описания нижнего среднего квадрата потребуется задать дополнительных 14 битов, указывающих, какие цифры числа √2 в нём используются. Наконец, для правого нижнего рисунка потребуется 9 битов — столько же, сколько и для рисунка над ним. Этот паттерн настолько мал, что здесь не поможет знание того, что это часть √2.

Дело ещё сильнее запутывается, когда доходит до информационного содержания малых частей. В верхнем ряду на рис. 12.7 всё обстоит так, как можно ожидать: чем меньше паттерн, тем он проще и тем меньше информации требуется для его описания — нам нужно по 1 биту для описания чёрного или белого пиксела. Но в нижнем ряду мы видим прямо противоположный пример. Здесь меньшее становится большим в том смысле, что средний паттерн сложнее левого, его описание требует больше битов. Теперь недостаточно просто сказать, что это двоичные цифры √2: следует также указать, с каких цифр начинается паттерн, а на это в данном случае потребуется ещё 14 битов. Короче говоря, целое может содержать меньше информации, чем сумма его частей, а иногда даже меньше, чем одна часть.

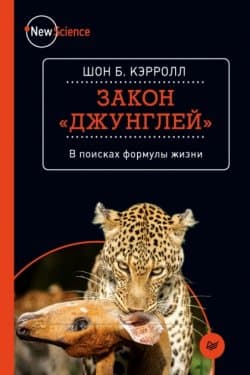

Закон «джунглей». В поисках формулы жизни Шон Б. Кэрролл

Закон «джунглей». В поисках формулы жизни Шон Б. Кэрролл

Первые 20 часов. Как быстро научиться… чему угодно Джош Кауфман

Первые 20 часов. Как быстро научиться… чему угодно Джош Кауфман

Формула счастья. Ничего + кое-что = всё Нил Пасрич

Формула счастья. Ничего + кое-что = всё Нил Пасрич

Восьмой навык. От эффективности к величию Стивен Кови

Восьмой навык. От эффективности к величию Стивен Кови

Достучаться до небес. Научный взгляд на устройство Вселенной Лиза Рэндалл

Достучаться до небес. Научный взгляд на устройство Вселенной Лиза Рэндалл

Десять самых красивых экспериментов в истории науки Джонсон Джордж Клейтон

Десять самых красивых экспериментов в истории науки Джонсон Джордж Клейтон

Наследник

Наследник  Пир теней

Пир теней  Князь во все времена

Князь во все времена  Когда порвется нить

Когда порвется нить